科研背景

联邦学习(Federated Learning)是一种分布式机器学习方法,旨在通过在本地设备上进行模型训练,同时保护用户数据的隐私。相比于传统的集中式机器学习方法,联邦学习将模型训练推送到用户设备上,让设备在本地使用本地数据进行模型训练,然后将模型参数的更新发送回中央服务器进行聚合,从而实现全局模型的改进。

联邦学习的核心目标是解决分散数据的隐私保护和数据安全性的问题。它适用于那些存在大量敏感数据的场景,例如移动设备、边缘计算环境或跨组织合作中的数据共享、

科研问题

- 在联邦学习中,参与方上传模型参数的更新,这可以暴露一些关于本地训练数据的信息。攻击者可以通过分析这些参数更新来推断参与方的训练数据,从而侵犯数据隐私。

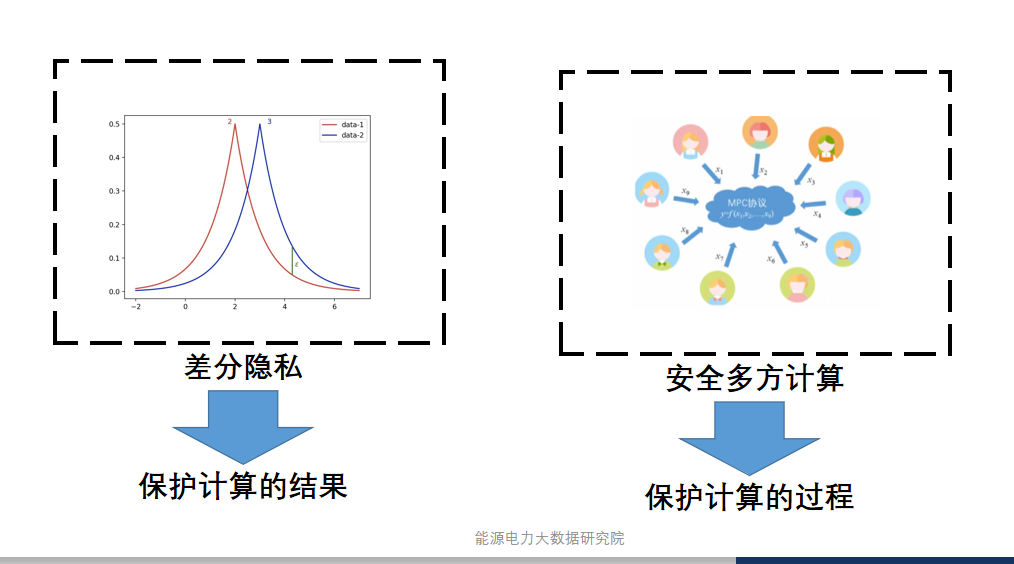

- 安全多方计算确保了参与方之间的计算安全性,但在传输数据和计算过程中,可能会暴露参与方的模型参数更新,这可能会导致攻击者利用这些信息进行数据推断攻击。

- 差分隐私通过在数据中引入噪声来保护隐私,但这会或降低数据的准确性和可用性,而且导致传输和计算的开销增加。

科研目的

提出一种差分隐私增强的安全联邦学习框架,将安全多方计算与差分隐私相结合,弥补彼此的缺点,提供更全面的隐私保护和数据效用。

系统模型

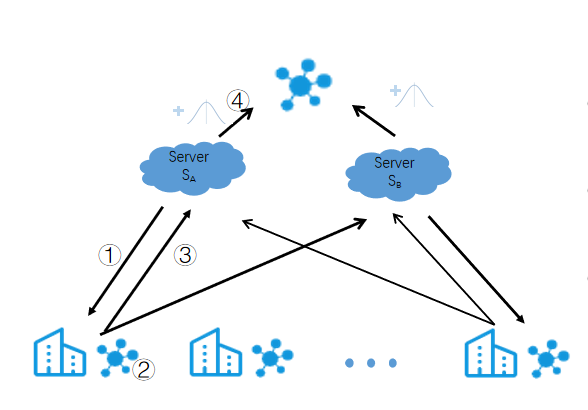

②本地模型更新

③将∆θ_t^i拆分成两个份额[∆θ_t^i]_A 和[∆θ_t^i]_B,分别发送到服务器S_A和S_B。

④添加噪声,由S_A或S_B聚合。