科研背景

深度学习中的后门攻击指将后门植入原模型中,在测试阶段,若样本中存在触发器则能够触发后门,模型由此得出特定的预测结果,否则模型表现正常。后门攻击适用的攻击场景多样,依据攻击媒介划分,攻击者可以通过控制深度学习供应链源头,给用户提供毒化后的第三方代码、硬件、数据 等 组 件,使模型训练过程受到毒化组件的影响从而被植入后门。如果攻击者能够控制训练平台,那么其可直接操纵模型而无须借助毒化数据等媒介。在模型部署甚至测试阶段,攻击者通过修改内存数据等方式依然能够实现后门攻击。

科研问题

深度神经网络DNN在开发过程中的不同阶段都容易受到攻击。这些攻击引发了DNN在安全关键场景(如人脸识别、自动驾驶和医疗诊断中发展的安全问题。因此,对这些攻击的研究对于安全性和鲁棒性的深度学习至关重要。

科研目的

提出新颖的后门攻击方法,利用自然环境中存在的现象设计后门触发器以提升后门攻击的隐蔽性与有效性,进一步为推动深度学习安全的发展提供有益参考。

研究内容

1、雾后门攻击,通过使用雾与输入图像叠加产生特定样本植入受害者模型。

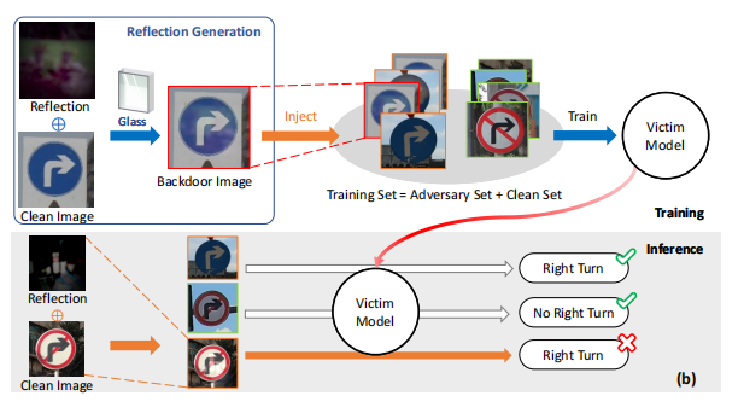

2、反射后门(Refool),将反射图像作为后门植入受害者模型。