上一次组会中介绍了大模型安全方向的现有工作。本次组会将介绍垂域大模型的搭建与记忆的研究工作和个人思考。

科研背景

”垂域大模型”(domain-specific large-scale models) ,经过训练或微调的通用模型。通过特定领域的知识进行增强,通过领域的目标进行优化,并通过特定领域的约束进行调节。

垂域大模型学术研究

1.领域指令微调

2.基于检索增强大预言模型存在记忆,本研究将探究记忆与隐私的联系

科研问题

基于预训练的大语言模型无法轻松扩展或修改记忆,如何为模型提供决策依据并更新模型的知识。

基于检索增强的文本生成模型的记忆影响,存在什么隐私问题。

研究目的

研究更优的为大预言生成模型提供参与记忆以外的知识,搭建“垂域”大模型

研究基于检索的文本生成增强系统中记忆的影响,根据最终应用平衡安全问题与模型性能

研究内容

知识密集型 NLP 任务的检索增强生成

贡献:提出一种用于检索增强生成(RAG)的通用微调方法,该模型结合了预先训练的参数和非参数记忆来生成语言。

SELF-INSTRUCT:使语言模型与自生成的指令保持一致

贡献: 通过引导模型自己的生成来提高预训练语言模型的指令跟踪能力,将预训练语言模型与指令对齐。

训练数据提取攻击

贡献:证明攻击者可以执行训练数据提取攻击,通过查询语言模型来恢复单个训练示例。

语言模型的抄袭

贡献:研究了预训练和微调的 LM 的抄袭行为。以两个研究问题为指导:预先训练的 LM 是否抄袭? 经过微调的 LM 是否抄袭?

实验复现

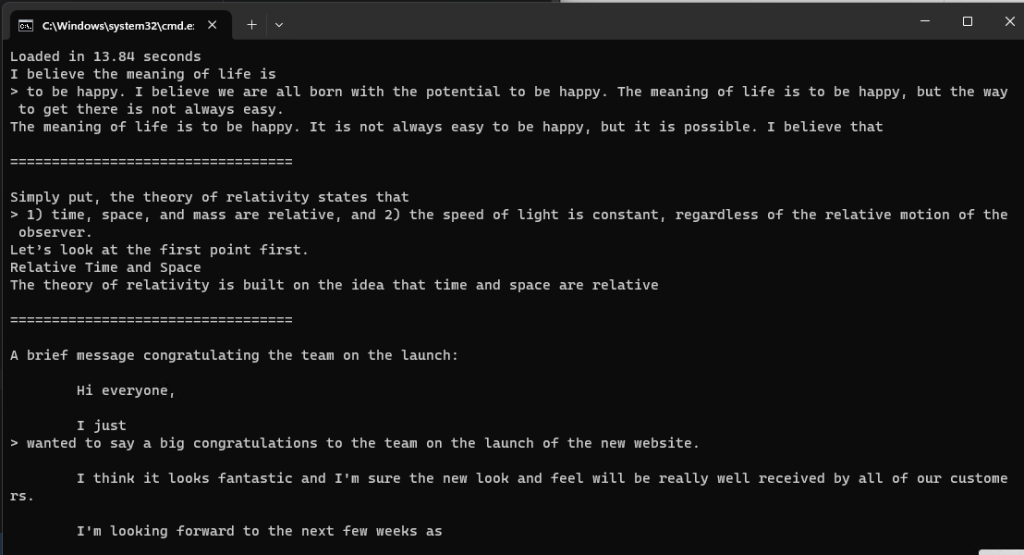

搭建本地LLAMA-2-7B语言模型