科研背景

FL容易受到中毒攻击在现实世界的应用程序中,一些恶意参与者可能希望通过恶意操纵他们的本地模型更新对训练的FL模型造成负面影响。这些攻击可能是非常有害的,因为即使是一小部分恶意参与者也会导致分类准确性大幅下降,并降低全局模型效用。为了减轻这些攻击并保持FL的可用性,提出了一些针对中毒攻击的防御方法。局部模型选择是通过将恶意参与者与良性参与者分离并防止恶意模型聚合来规避中毒攻击的常见方法。由于该防御方法包含大量的非线性运算,安全计算量大,因此要实现一个实用的、保护隐私的、抗中毒攻击的拜占庭鲁棒FL方案具有挑战性。

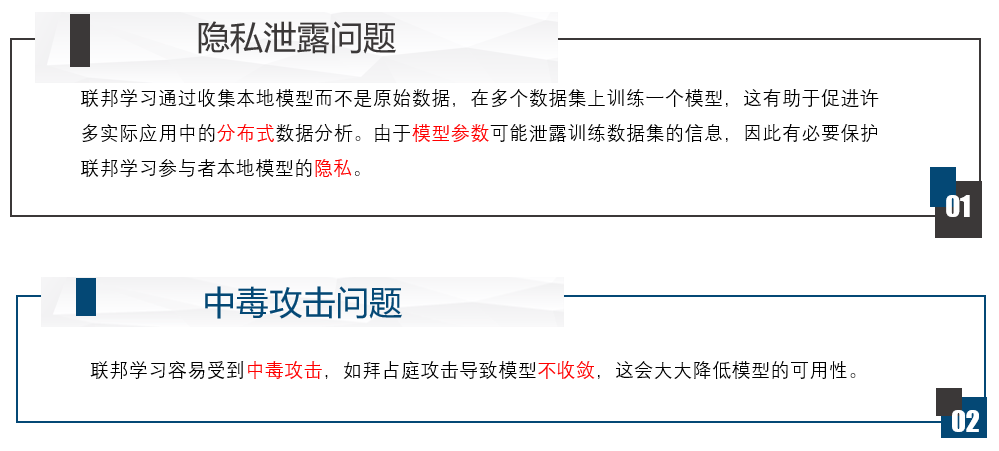

科研问题

研究目的

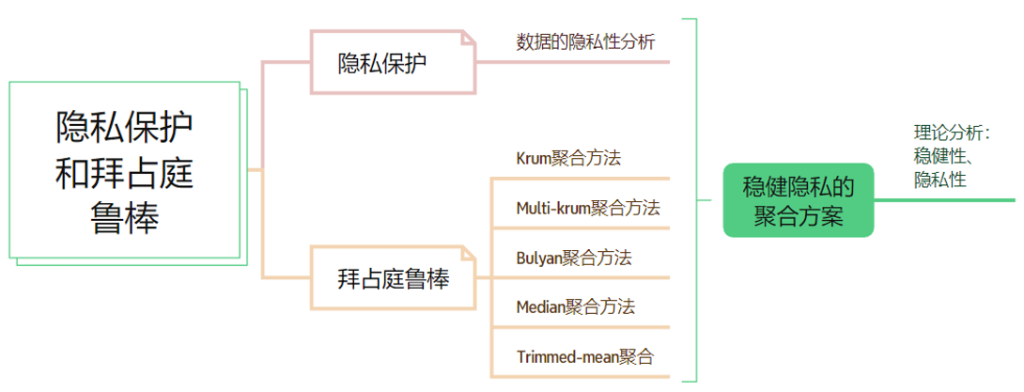

研究内容