Detection Tolerant Black-Box Adversarial Attack Against Automatic Modulation Classification With Deep Learning

本次组会主要分享一篇跟对抗攻击有关的论文《Detection Tolerant Black-Box Adversarial Attack Against Automatic Modulation Classification With Deep Learning》,主要从科研背景,科研问题,科研目的,研究内容以及评价几个方面来阐述。

科研背景

- 基于DL的AMC(自动调制分类):随着无线通信技术,特别是数字通信技术的发展,调制技术变得越来越复杂。在此场景下,AMC逐渐取代了传统的人工调制分类方法,传统的人工调制分类方法需要训练有素的操作员和特殊的设备,并广泛应用于无线通信。

- 对抗样本攻击:攻击人通过对输入进行一些人类无法察觉的扰动,从而实现欺骗神经网络的目的。

- 模型提取攻击:攻击者将查询的输出收集到目标模型,这有助于计算或推断模型的内部知识。

科研问题

1.现有的大多数对抗攻击方法都做了过于理想化的假设,造成了DL系统可以被简单攻击的假象,制约了对DL系统的进一步改进。

2.由于DL固有的安全问题,各种对抗性示例攻击可以导致基于DL的调制识别系统的精度损失或错误分类。

3.目前针对AMC系统的对抗性攻击主要是在白盒设置下进行的。然而,为了保护模型产权,模型所有者或机器学习平台通常不会公开其模型的内部信息。这使得直接白盒攻击几乎不可能

科研目的

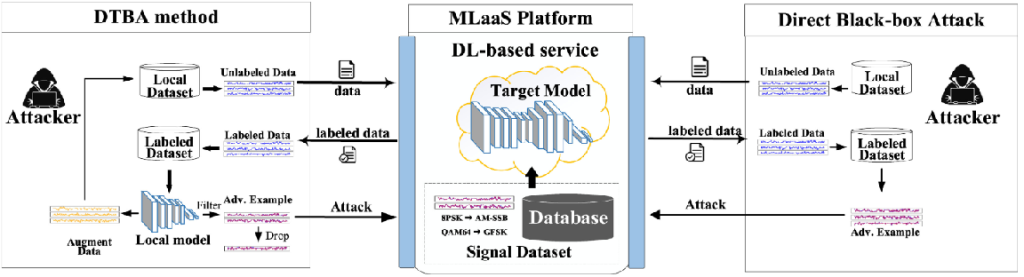

1.提出了一种针对基于DL的自动调制分类(AMC)的容忍检测黑盒对抗攻击(DTBA)方法,可以极大地降低对抗样本攻击的检测概率。

2.DTBA方法通过删除70%以上的无效查询,降低攻击成本,同时将攻击成功率提高了20%以上

研究内容

(2)利用局部模型过滤出的对抗样本来误导目标模型,使其误分类