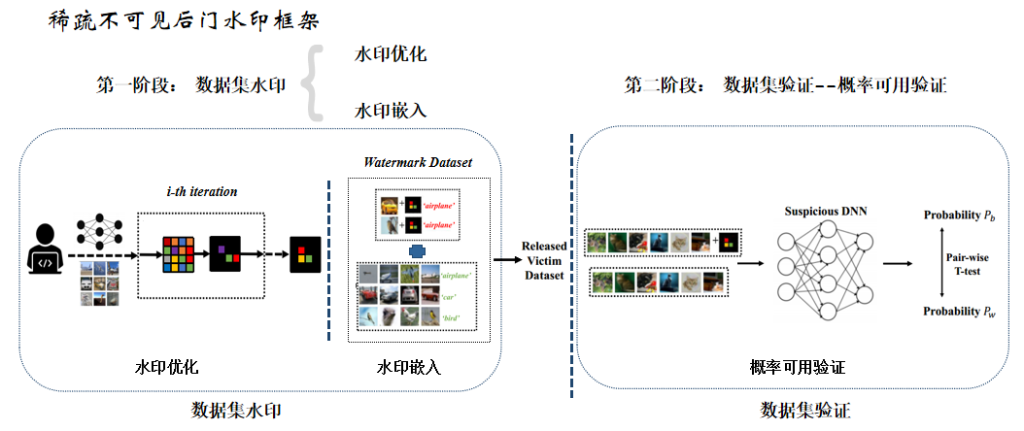

基于稀疏不可见后门水印的数据集保护技术研究

基于稀疏不可见后门水印的数据集保护技术研究

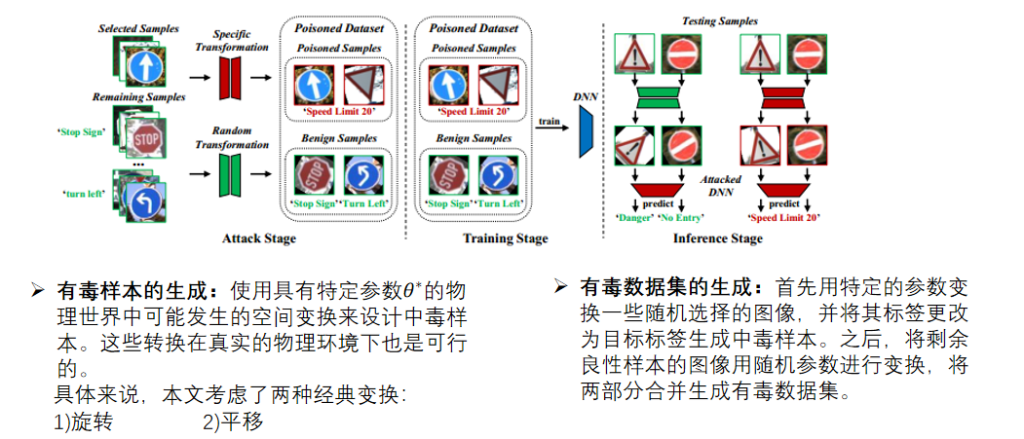

基于空间变换的动态数据集水印

研究问题:针对于图像分类任务的开源数据集的保 护,现有的基于后门水印的方法都是静态的。这种静态的水印很容易遭受到裁剪攻击或者 在数据集处理时被缩放、翻转等空间变换剔除掉。

研究目的:设计出一种动态的(基于图像本身做空间变换的)、隐蔽的后门水印方法,能够验证数据集的所有权,保护数据集所有者的版权。

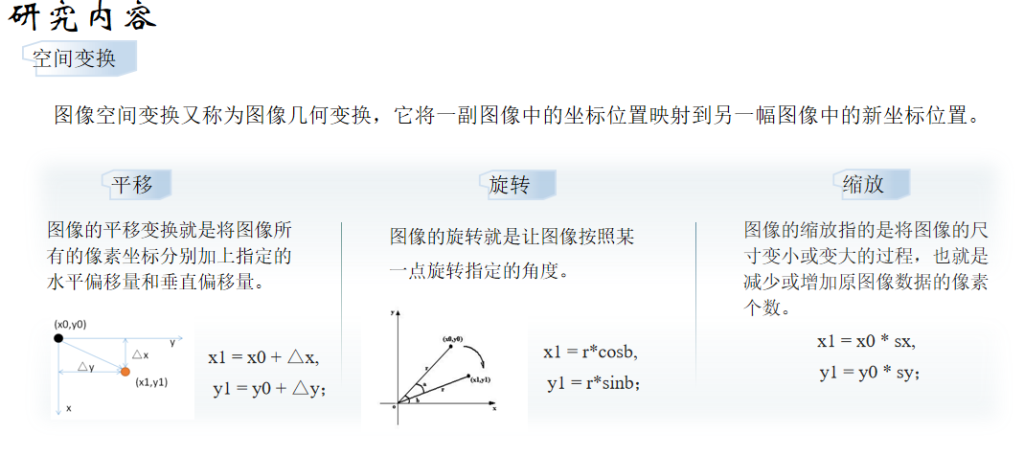

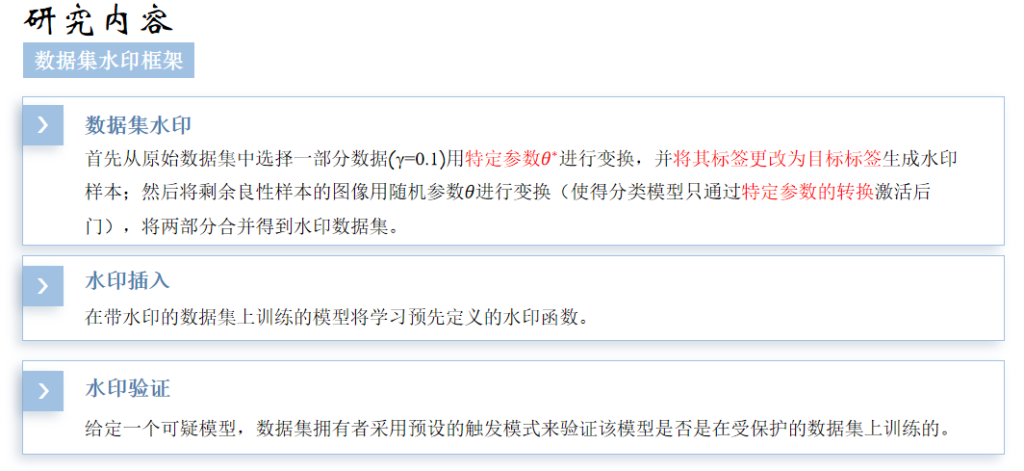

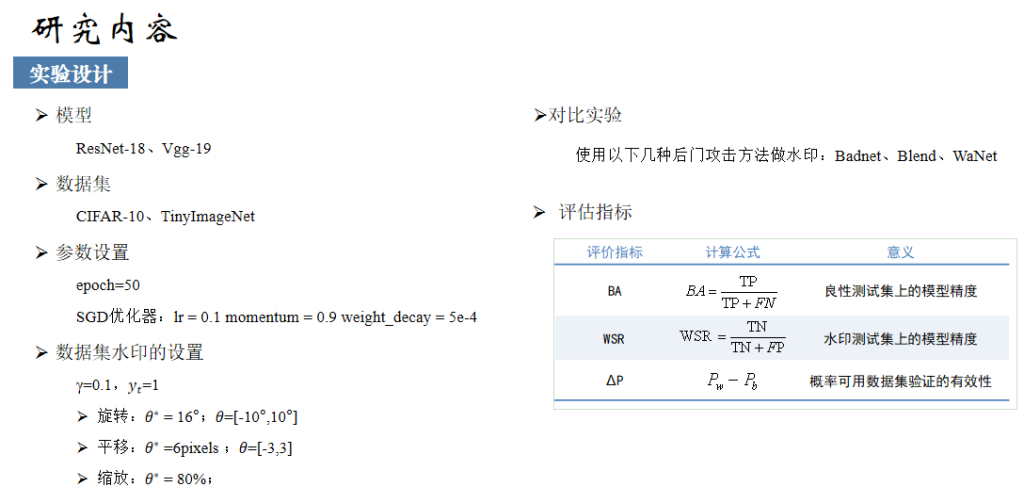

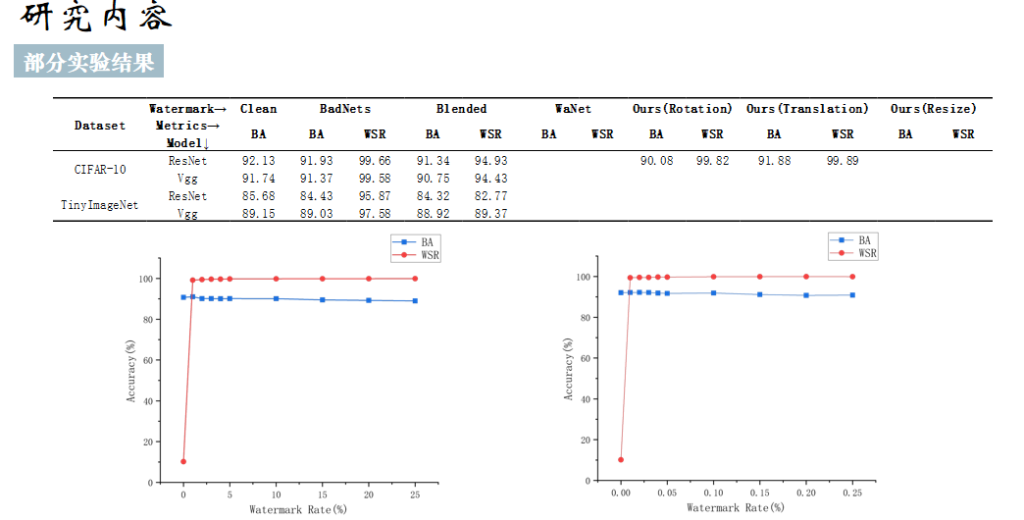

研究内容:

科研背景

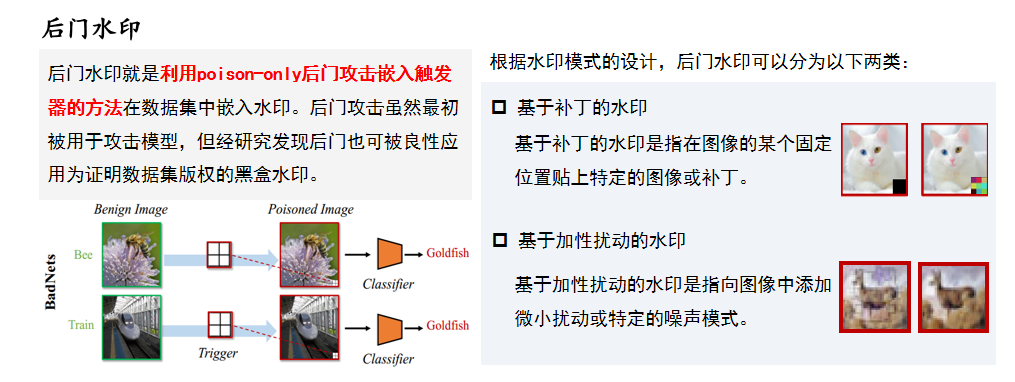

后门攻击是利用深度神经网络的过拟合能力, 通过训练、调参等方法使其学习触发器的特征,在触发器和目标标签之间建立潜在的联系。

后门攻击的场景

使用第三方数据集:攻击者可以修改训练数据集;防御者可以修改任何东西,包括模型结构、训练集等。

使用第三方训练平台:攻击者可以修改除了模型数据以外的任何东西;防御者则无法访问实际的训练集和训练模式,只能访问良性测试集。

使用第三方模型:攻击者可以修改任何东西,包括模型结构,训练集等;防御者则无法访问训练集和训练模式,只能访问良性测试集。

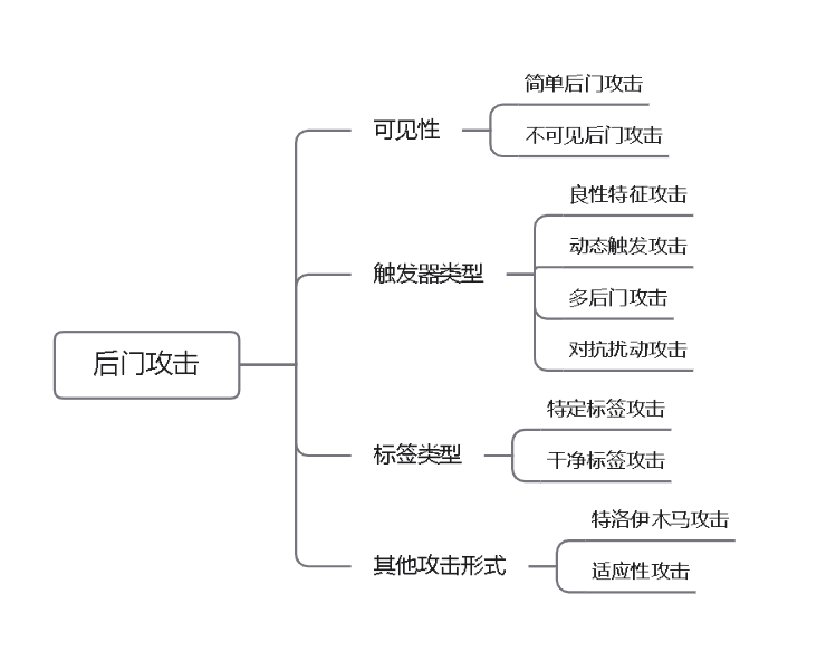

后门攻击的分类

科研问题

在大多数这些工作中,触发模式是基于补丁扰动或图像混合。然而,这些后门触发是不自然的,很容易被人类发现。现有的不可见的触发后门攻击在物理世界中表现不佳。

研究目的

设计一种在物理世界表现良好且隐蔽的后门攻击

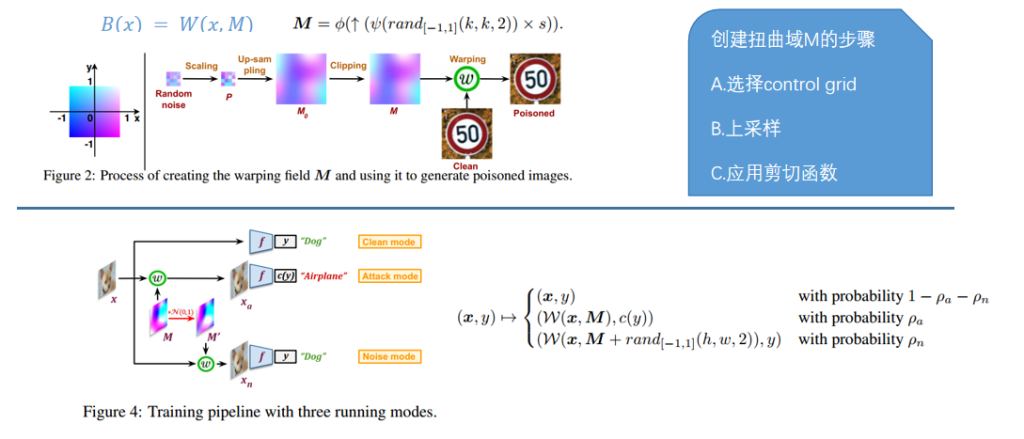

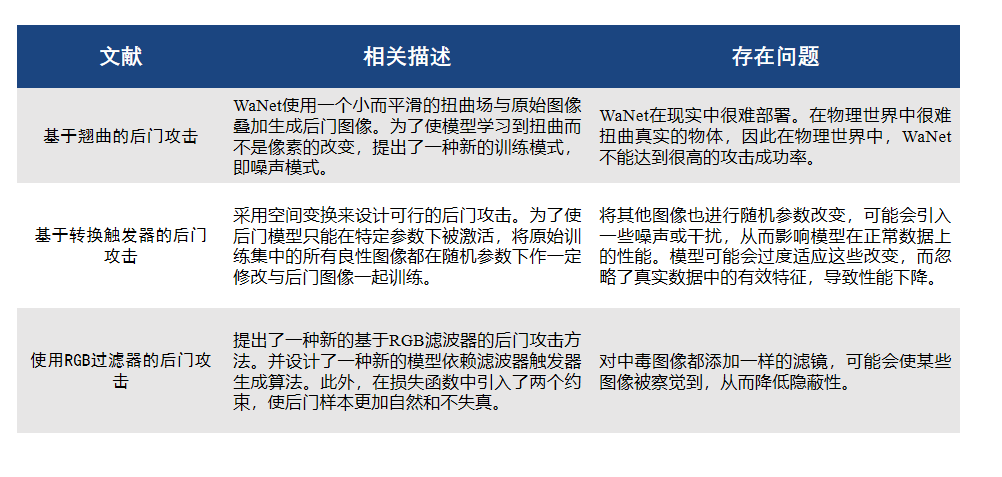

研究内容1-基于翘曲的后门攻击

研究内容2-基于转换触发器的后门攻击

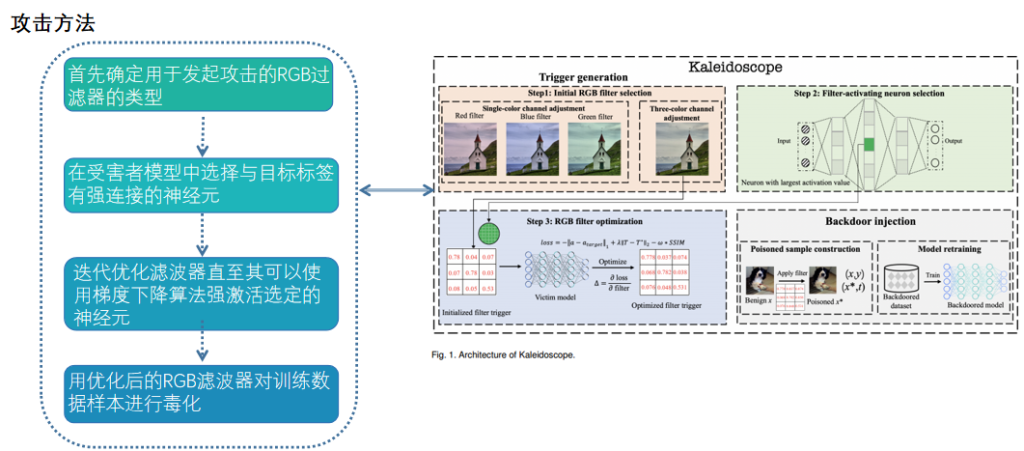

研究内容3-使用RGB过滤器的后门攻击

总结

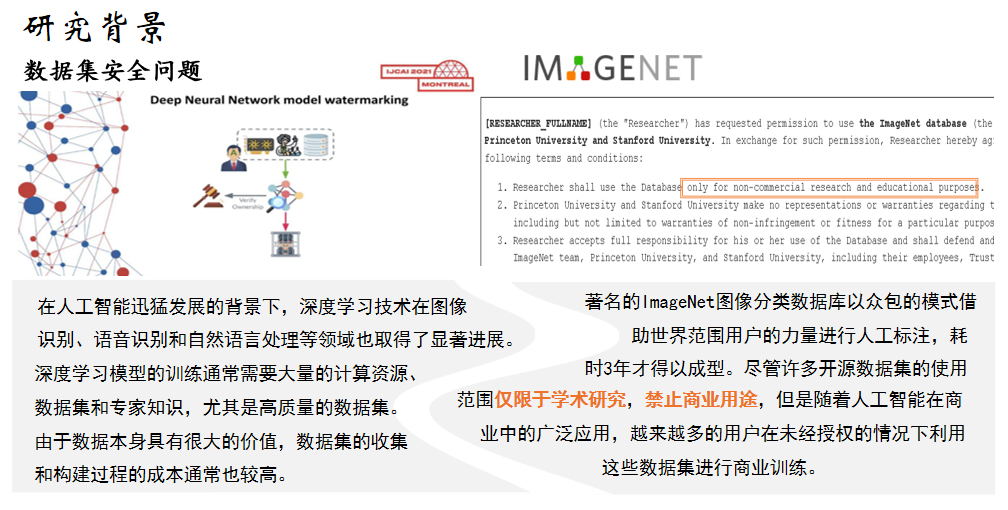

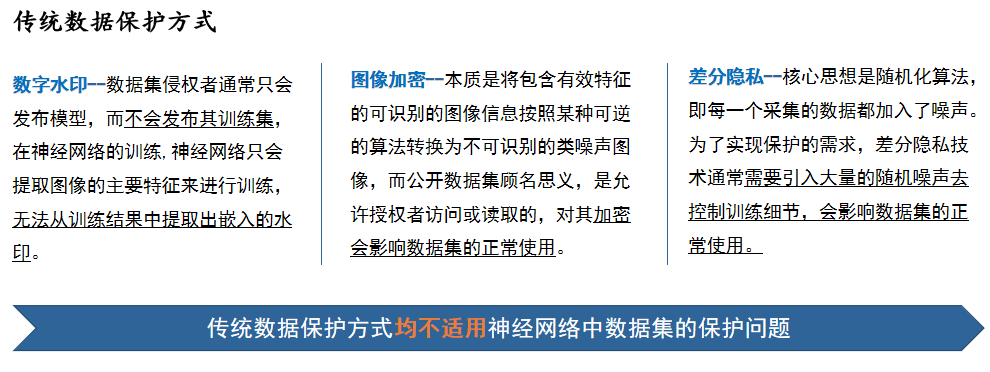

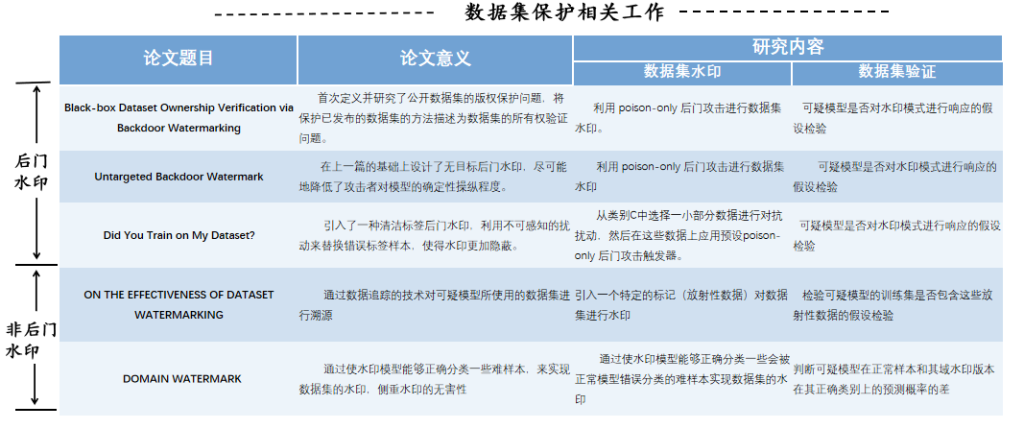

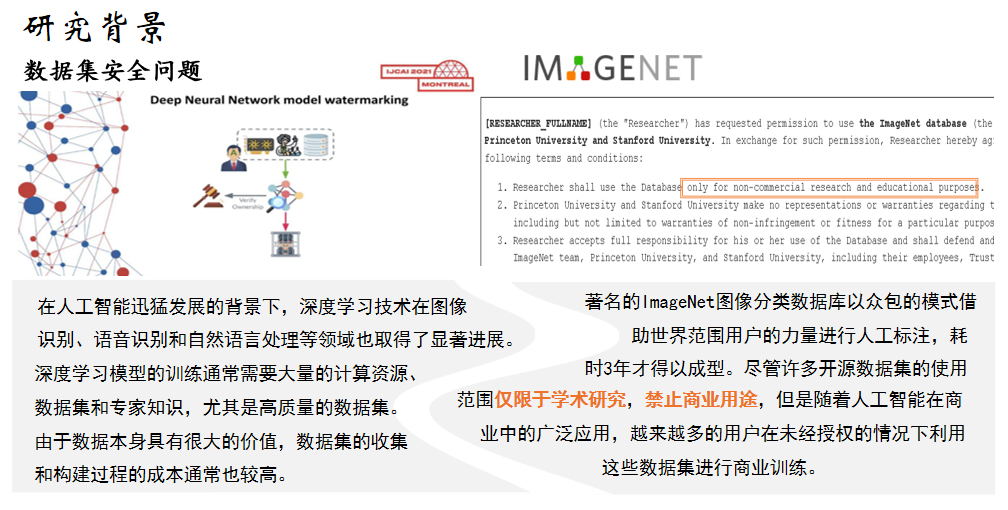

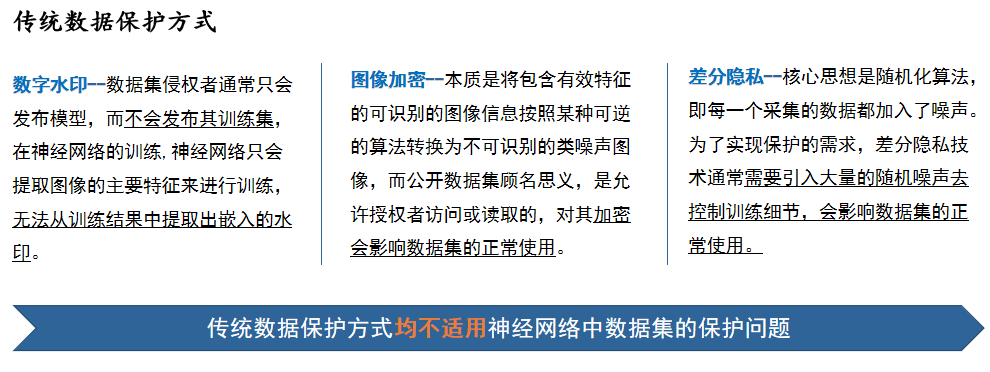

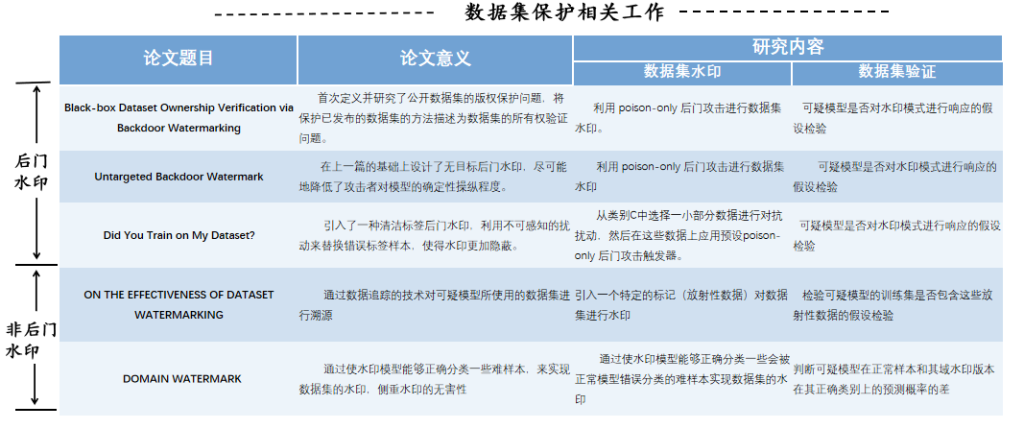

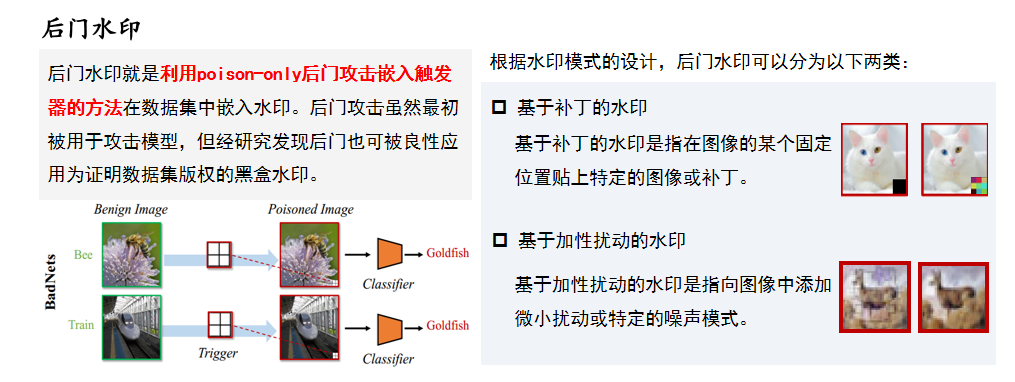

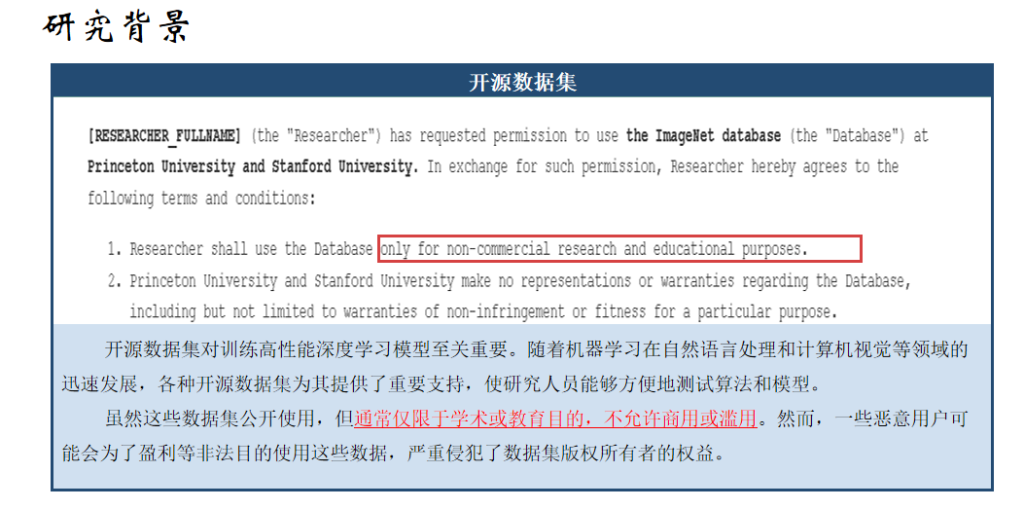

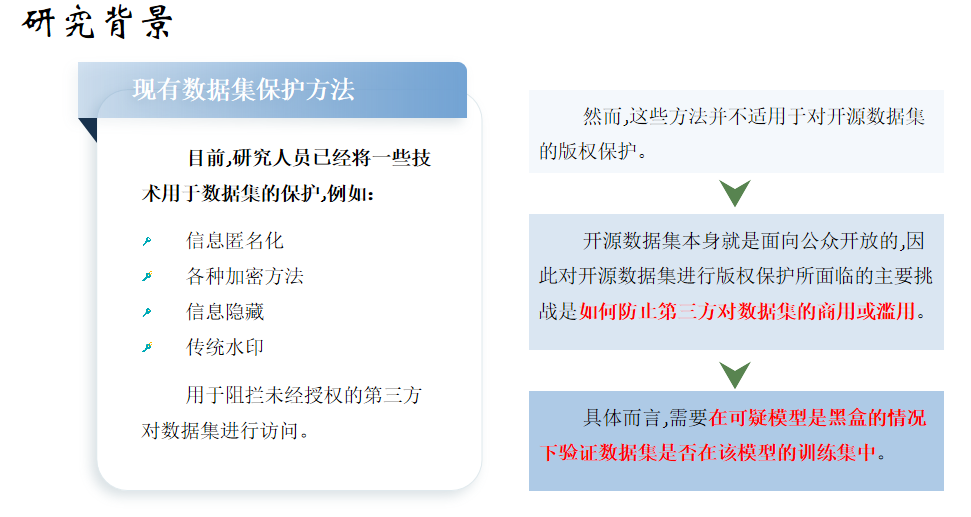

研究背景

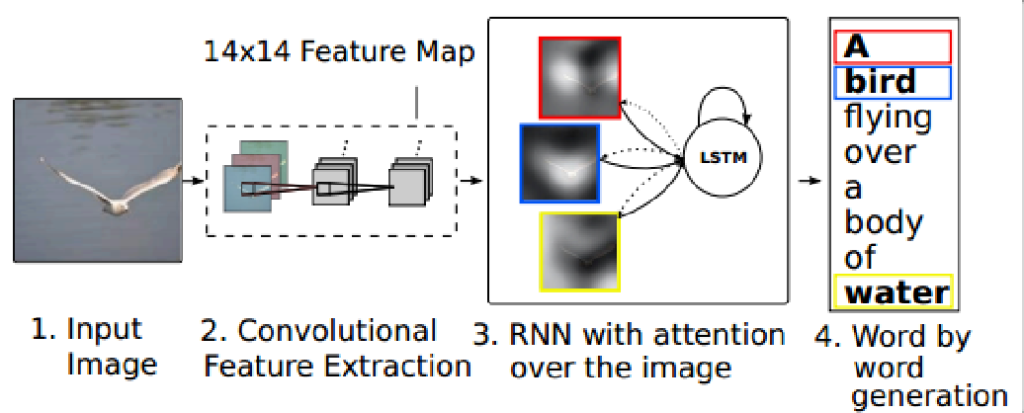

图像描述任务的输入为图像I,输出为由N个单词组成的图像文本描述S={s1,s2,···,sN},旨在利用计算机自动为已知图像生成一个完整、通顺、适用于对应场景的描述语句,实现从图像到文本的跨模态转换。

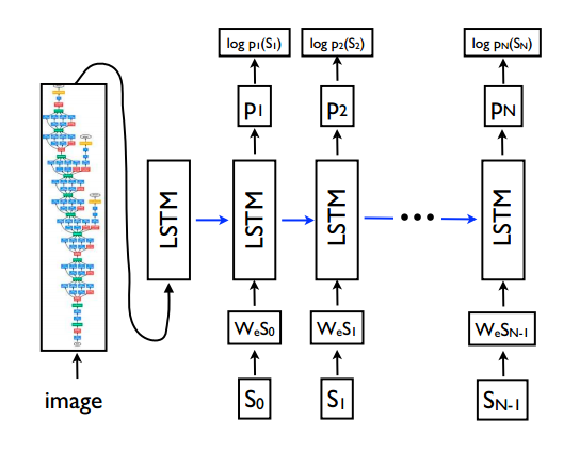

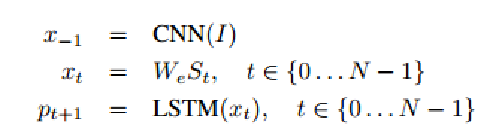

经典图像描述模型–NIC

用I表示输入图像,用S = (S0, . . . , SN ) 表示描述该图像的真句,其框架展开过程如下:

经典图像描述模型-CNN+LSTM+注意力机制

在NIC的基础上引入了注意力机制,将图像生成的描述的每一个单词都对应到图像的某一个区域

科研问题

对于图像字幕模型发起攻击可能会生成一些与攻击者预先定义的图像无关的特定字幕,攻击者可能会通过控制特定的标题来制造社会恐慌或引导舆论。

有一些针对图像字幕的对抗性攻击的研究,但它们的目的是制作对抗性示例,主要使用基于优化的方法,以操纵图像字幕模型的生成结果作为目标句子或单词。

且针对图像分类任务的后门攻击已经被广泛研究并被证明是成功的,但针对视觉语言模型的后门攻击研究却很少

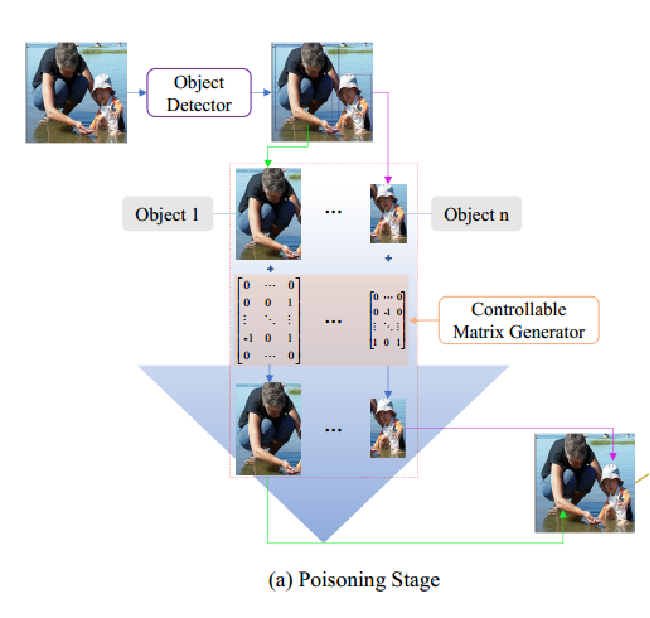

研究内容

在模型中插入一个后门,后门模型在中毒图像上生成攻击者定义的句子或单词,同时不降低模型在正常图像上的性能。

在构建中毒样本的过程中,提出了一种基于对象的毒物生成方法。

图像字幕后门攻击的目的是在图像字幕模型中创建后门,该后门适用于跨模态领域。

科研背景

深度学习中的后门攻击指将后门植入原模型中,在测试阶段,若样本中存在触发器则能够触发后门,模型由此得出特定的预测结果,否则模型表现正常。后门攻击适用的攻击场景多样,依据攻击媒介划分,攻击者可以通过控制深度学习供应链源头,给用户提供毒化后的第三方代码、硬件、数据 等 组 件,使模型训练过程受到毒化组件的影响从而被植入后门。如果攻击者能够控制训练平台,那么其可直接操纵模型而无须借助毒化数据等媒介。在模型部署甚至测试阶段,攻击者通过修改内存数据等方式依然能够实现后门攻击。

科研问题

深度神经网络DNN在开发过程中的不同阶段都容易受到攻击。这些攻击引发了DNN在安全关键场景(如人脸识别、自动驾驶和医疗诊断中发展的安全问题。因此,对这些攻击的研究对于安全性和鲁棒性的深度学习至关重要。

科研目的

提出新颖的后门攻击方法,利用自然环境中存在的现象设计后门触发器以提升后门攻击的隐蔽性与有效性,进一步为推动深度学习安全的发展提供有益参考。

研究内容

1、雾后门攻击,通过使用雾与输入图像叠加产生特定样本植入受害者模型。

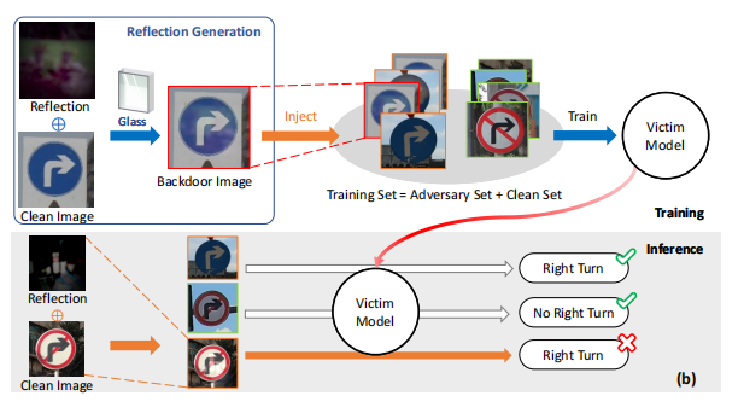

2、反射后门(Refool),将反射图像作为后门植入受害者模型。